Технический SEO-аудит сайта

Это 2ой этап работы над продвижением сайта.

Получить полную картину работ по Оптимизации сайта поможет эта статья.

Технический аудит в первую очередь направлен на то, чтобы наши будущие работы по контенту были видны для поисковых систем. Ваш главный «враг» — CMS сайта. Многие системы для администрирования сайтов не заточены под SEO, да и студии в абсолютном большинстве знают про Оптимизацию очень мало (но это и не их работа).

В этой статье расскажу куда смотреть и что искать при техническом SEO-аудите сайта.

Технический аудит

Количество страниц сайта в базе Яндекс и Google

Если страниц больше нуля, значит Поисковая система видит сайт. Это уже плюс.

Как проверить?

А. Использовать данные вебмастеров

Б. Использовать оператор поиска

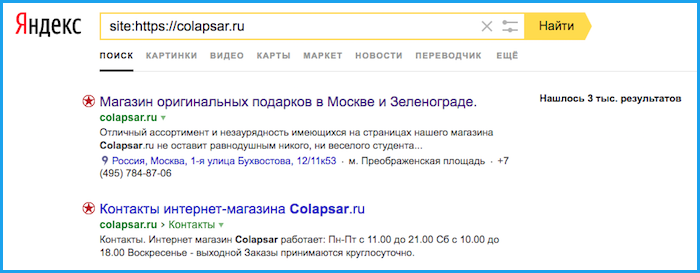

Пример: если ввести в поисковую строку запрос «site:https://colapsar.ru» (без ковычек), то увидим что сейчас в индексе находится примерно 3000 страниц — Яндекс и 2960 — Google.

Файл robots. txt

• Файл должен существовать

• В нем надо разделить блоки для разных поисковых систем. Я обычно делю их на 2 или 3 части: для Яндекса, Google и для всех остальных

• Закрыть от индексации все ненужные страницы. Важно знать, что в Индекс попадают даже страницы с разными метками. Поэтому я по умолчанию добавляю в этот файл операторы:

Disallow: /*?_openstat=

Disallow: /*?gclid=

Disallow: /*?utm_source=

Disallow: /*from=adwords

О том как создавать и редактировать файл можно почитать на Яндекс.Помощь

Хороший пример реализации файла — www.ozon.ru/robots.txt

Карта сайта (страница)

Это страница со ссылками на все нужные страницы сайта. Она позволяет поисковому роботу за один раз проиндексировать весь сайт. Такая страница страхует функционал файла sitemap. xml от непредвиденных ошибок.

Пример реализации — corpshark.ru/map

Карта сайта (sitemap.xml)

Файл с адресами страниц, которые надо проиндексировать. Обязателен к использованию.

О том как создавать и редактировать файл можно почитать на Яндекс.Помощь

Ответ сервера

Для существующих и нужных страниц, сервер сайта должен отдавать код ответа 200.

Типичный пример такой ошибки — Страница 404 отдает код ответа 200 вместо кода ответа 404. Это значит, что Поисковая система считает эту страницу существующей и добавляет в Индекс. Обилие мусора в Индексе приведет к общему снижению позиций всех страниц сайта.

Как проверить ответ сервера? Используйте любой бесплатный сервис, например:

webmaster.yandex.ru/tools/server-response

bertal.ru

Редиректы

Наличие большое количества редиректов на сайте - это крайне опасная штука. Поисковые системы не любят редиректы. Использовать желательно только 301 редирект

HTTP и HTTPS

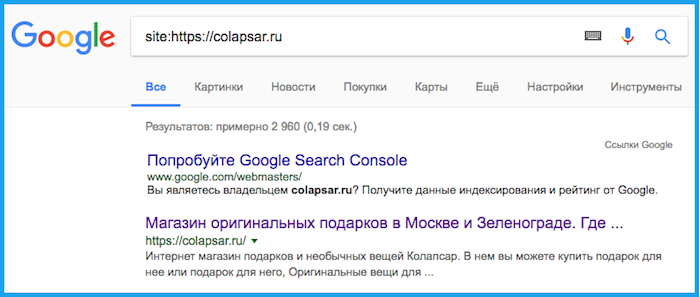

Если сайт доступен по двум протоколам, то в индексе будет находиться полная копия сайта. Это создаст дополнительную конкуренцию, что нам категорически не нужно. Вывод: сайт должен быть доступен только по одному протоколу. Это упростит вам жизнь и позволит поисковым системам выкинуть дублирующие себя страницы из индекса. В современных реалиях лучше использовать HTTPS. Особенно это важно для Ecommerce проектов, банков, МФО и других сайтов, связанных с финансовыми операциями.

Например браузер Google Chrome уже указывает пользователю сайты, работающие на HTTPS, как надежные.

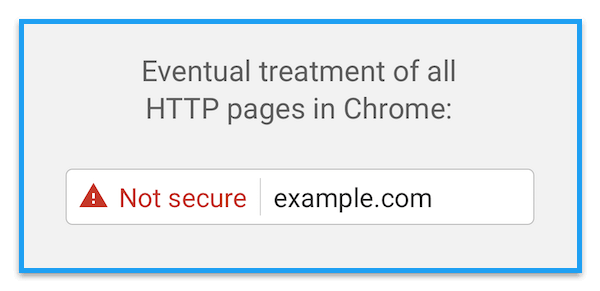

В конце концов разработчики браузера планируют перейти к маркировке HTTP-сайтов, как ненадежных. Это может негативно сказаться на доверии пользователей и уровне конверсии.

В конце концов разработчики браузера планируют перейти к маркировке HTTP-сайтов, как ненадежных. Это может негативно сказаться на доверии пользователей и уровне конверсии.

Псевдостатические адреса страниц (ЧПУ)

Запомните постулат: динамическая адресация страниц на сайте — это ЗЛО. Такая адресация препятствует правильной индексации сайта, поскольку в индексе образуется большое количество страниц-дублей, связанных с тем, что параметры могут переставляться или менять свой состав. Поисковые машины умеют различать динамические и статические URL’ы и определенным образом ограничивают число индексируемых страниц сайта с динамическими адресами. Никаких знаков вопроса, решеток и другого мусора не должно быть в адресах важных нам страниц

Абсолютная адресация ссылок

В коде сайта ссылки должны иметь полные адреса, включающие в себя домен сайта. В некоторых CMS это не предусмотрено и домен сайта обрезан. Поисковая система за вас о вашем сайте не подумает;)

Страницы-дубли

На сайте по разным причинам могут находиться страницы, которые имеют разные адреса, но полностью совпадающий контент. Это например страницы: site.ru и www.site.ru. Такие страницы надо выжигать каленым железом

Внешние исходящие ссылки

Корректное оформление внешних исходящих ссылок — важный момент сохранения ссылочного веса сайта. Если закрыть их от поисковых систем, то ссылочный вес не должен перетекать на сторонние сайты. Конечно все зависит от стратегии продвижения. Но в большинстве случаев внешние ссылки рекомендуется закрывать тегами.

<a href="link" rel="nofollow">Text</a> - для Google

<noindex>link</noindex> - для Яндекса

Если ваш сайт сделан на Wordpress, то есть специальный плагин WP No External Links

Неуникальные тексты

Взял текст с чужого сайта — будь уверен, что твой сайт будет на низких позициях в выдаче (при прочих равных условиях). Это правильно лучше не нарушать, особенно молодым сайтам.

Как проверить текст на уникальность? Использовать сервисы:

www.etxt.ru/antiplagiat

text.ru

Дублирующиеся тексты

Возьмите за правило: Один текст = одна страница. Не стоит размещать один и тот же текст, на разных страницах своего сайта

Переоптимизированные тексты

Были в моей практике и такие ситуации, когда каждое 10е слово в тексте было ключевым. Поисковые системы давно научились распознавать и жестко карать за такие вещи. Просто помните об этом

«Битые» ссылки

Ссылки, ведущие внутри вашего сайта на страницы, которых уже не существует, называются «битыми», то есть не работающими. Чем меньше таких ссылок, тем лучше.

Как проверить? Например здесь: validator.w3.org/checklink

Внутренняя перелинковка

Для улучшения связанности страниц между собой используют этот инструмент. Особенно полезен и релевантен он в блогах, когда одна публикация ссылается на другие публикации на этом же сайте

Оптимизация HTML-кода страниц

Тут ошибки просто найти, но бывает сложно исправить.

Пользуйтесь инструментом от Google: developers.google.com/speed/pagespeed/insights

Сжатие изображений

Чем меньше изображения, тем быстрее они загружаются, тем быстрее работает сайт. Скорость работы сайта важна не только для бизнеса и юзабилити, но и для поисковых систем.

Какие изображения и как сжать? Расскажет developers.google.com/speed/pagespeed/insights

Вы держитесь здесь! Хорошего вам настроения и здоровья!

Другие статьи из цикла «Оптимизация сайта для новичков»:

1. SEO для новичков

2. Технический SEO-аудит сайта (эта статья)

3. Как собрать семантическое ядро для сайта

4. Контентный аудит

5. Юзабилити аудит (не опубликована)

6. Увеличение ссылочной массы сайта

7. Оценка результатов оптимизации (не опубликована)